RAG vs Fine-Tuning: Lo que Hemos Aprendido Eligiendo Entre Ambos

Reflexiones sobre cuándo usar RAG, cuándo fine-tuning, y por qué la respuesta casi nunca es tan simple como parece. Incluye las nuevas tendencias de 2025: GraphRAG, Agentic RAG y enfoques híbridos.

Cuando empezamos a trabajar con modelos de lenguaje para aplicaciones empresariales, una de las primeras decisiones que tuvimos que tomar fue cómo hacer que el modelo “supiera” sobre el dominio específico del cliente. La respuesta parecía simple: RAG o fine-tuning. Dos opciones, elige una.

La realidad resultó ser bastante más matizada. Y después de varios proyectos, hemos aprendido que la pregunta correcta no es “¿cuál es mejor?” sino “¿qué problema estamos intentando resolver exactamente?”

Este artículo comparte lo que hemos aprendido, incluyendo las nuevas tendencias que están cambiando el panorama en 2025.

Los conceptos básicos (para quienes lleguen nuevos)

Antes de entrar en detalle, una explicación rápida de cada enfoque.

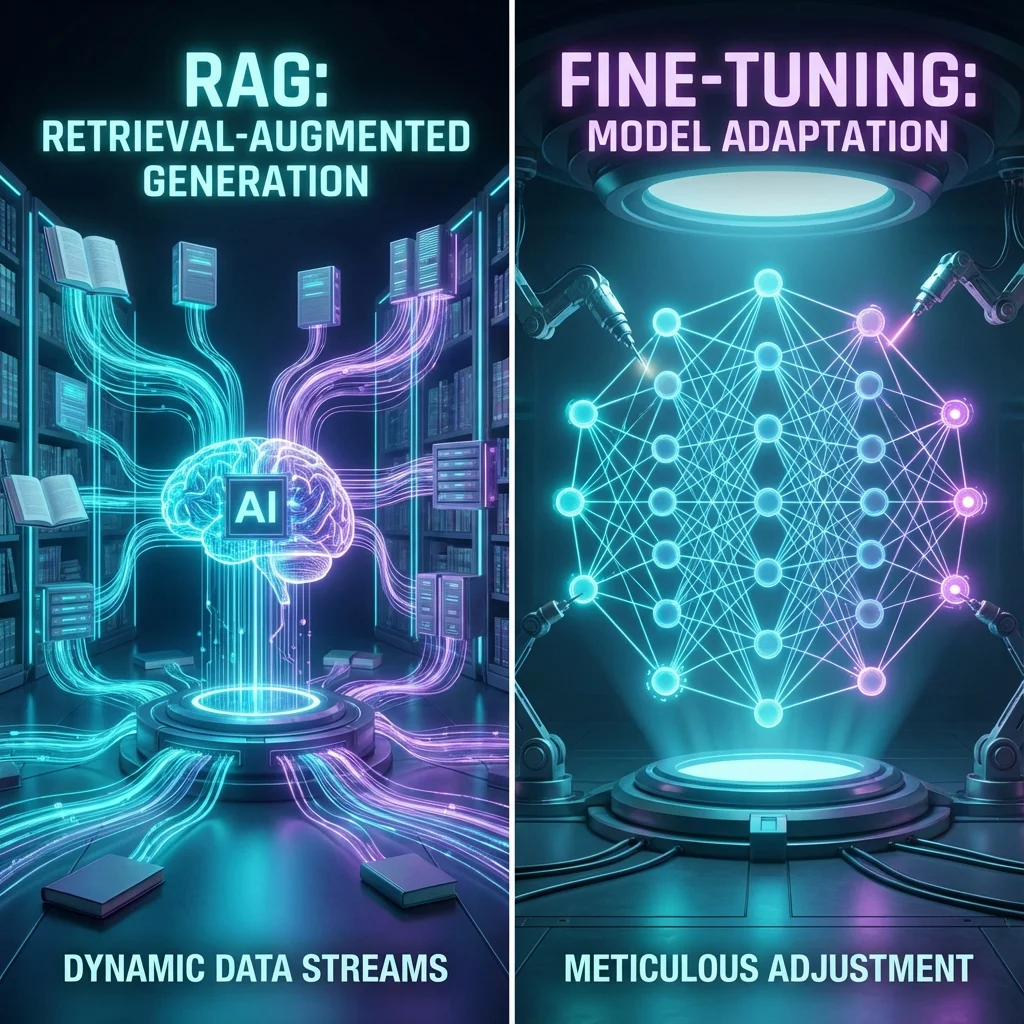

RAG (Retrieval-Augmented Generation) significa que el modelo base no cambia. Cuando alguien hace una pregunta, primero buscamos en una base de documentos los fragmentos más relevantes, y se los pasamos al modelo como contexto adicional. El modelo responde usando esa información.

Fine-tuning significa modificar los pesos del modelo entrenándolo con ejemplos específicos de tu dominio. El modelo “aprende” ese conocimiento y lo incorpora de forma permanente.

Una analogía que nos ha resultado útil: RAG es como darle a alguien acceso a una biblioteca antes de responder una pregunta. Fine-tuning es como que esa persona estudie durante meses y memorice el contenido.

Ambos enfoques tienen su lugar. El reto está en saber cuándo usar cada uno.

Lo que realmente importa al elegir

Después de varios proyectos, hemos identificado las preguntas que realmente determinan la elección.

¿Con qué frecuencia cambia tu conocimiento?

Esta es probablemente la pregunta más importante. Si tus datos se actualizan constantemente (precios de mercado, inventario, normativa vigente, noticias), RAG es casi obligatorio. Actualizas los documentos en tu base de conocimiento y el sistema refleja los cambios inmediatamente.

Con fine-tuning, cada actualización significativa requiere reentrenar el modelo. Según IBM, esto hace que RAG sea “indispensable para aplicaciones sensibles al tiempo”. En nuestra experiencia con datos del sector oleícola, donde los precios cambian semanalmente, RAG era la única opción viable.

¿Necesitas saber de dónde viene cada respuesta?

RAG tiene una ventaja importante que a menudo se subestima: trazabilidad. Puedes mostrar exactamente qué documento usó el modelo para generar cada respuesta. Esto es crítico para cumplimiento normativo, para que el usuario pueda verificar fuentes, y para entender por qué el modelo respondió algo incorrecto cuando lo hace.

Con fine-tuning, el conocimiento queda “difuso” en los pesos del modelo. No hay forma de saber de dónde vino una afirmación específica. Como señala Red Hat en su comparativa, “el modelo tiene el conocimiento interno, pero no tiene una ‘verdad’ contra la cual comparar”.

¿Quieres cambiar qué sabe o cómo responde?

Esta distinción es clave y no siempre está clara al principio.

Si quieres que el modelo tenga acceso a información específica de tu empresa (documentos, políticas, datos), RAG es generalmente mejor. El modelo ya sabe “hablar”; solo necesita acceso a tu información.

Si quieres cambiar el comportamiento del modelo (su tono, estilo, formato de respuesta, nivel de detalle), fine-tuning es más efectivo. Según SuperAnnotate, “el fine-tuning te permite ajustar el comportamiento de un LLM, su conocimiento específico de dominio y su estilo de escritura para alinearse con matices y terminología específicos”.

Un radiólogo que ha hecho fine-tuning de un modelo con miles de informes radiológicos, por ejemplo, obtiene no solo la terminología correcta sino también el formato preciso que esperan los profesionales, las frases estándar para describir hallazgos, y el enfoque sistemático para documentar observaciones. Esto es difícil de lograr solo con RAG.

El panorama ha cambiado en 2025

Cuando empezamos a trabajar con estas tecnologías, el debate era bastante binario: RAG o fine-tuning. Pero el campo ha evolucionado significativamente. Hay varias tendencias que merece la pena conocer.

Búsqueda híbrida

El RAG tradicional usa búsqueda semántica (embeddings vectoriales) para encontrar documentos relevantes. Pero hemos aprendido, y la investigación lo confirma, que combinar búsqueda semántica con búsqueda por palabras clave (lo que se llama “hybrid search”) suele dar mejores resultados.

Un informe de IBM Research titulado “BlendedRAG” demostró que combinar búsqueda vectorial, búsqueda sparse y búsqueda full-text consigue mejor recall que cualquiera de los métodos por separado. En la práctica, esto significa que el sistema encuentra documentos relevantes que la búsqueda puramente semántica habría pasado por alto.

GraphRAG

El RAG tradicional tiene una limitación: funciona muy bien para preguntas puntuales (“¿cuál es la política de devoluciones?”) pero peor para preguntas que requieren sintetizar información de múltiples fuentes (“¿qué temas emergen en las quejas de clientes del último trimestre?”).

GraphRAG, popularizado por Microsoft, construye un grafo de entidades y relaciones sobre tu corpus de documentos. Esto permite responder preguntas “globales” que requieren conectar información dispersa. Según los análisis del sector, GraphRAG “permite recuperación contextual explorando la estructura del grafo” y “consultas multi-hop que las bases de datos de grafos manejan naturalmente”.

No es para todos los casos de uso, pero para dominios complejos con muchas relaciones entre conceptos (legal, médico, técnico), puede ser muy potente.

Agentic RAG

Quizás la tendencia más interesante de 2025 es lo que se llama “Agentic RAG”. En lugar de un pipeline fijo (pregunta → búsqueda → respuesta), el sistema usa agentes autónomos que pueden planificar múltiples pasos de recuperación, elegir herramientas, reflexionar sobre respuestas intermedias y adaptar su estrategia.

Según Gartner, para 2028 el 33% de las aplicaciones empresariales incluirán IA agéntica, frente a menos del 1% en 2024. Es un cambio significativo.

Pero hay un matiz importante: la investigación muestra que los sistemas Agentic RAG, aunque son los que mejor funcionan, todavía tienen rendimiento modesto en datos empresariales complejos. Un estudio de benchmarking encontró que el mejor sistema agéntico solo alcanzaba un rendimiento promedio de 32.96 sobre 100. Hay mucho margen de mejora.

Self-RAG y Corrective RAG

Otras variantes que están ganando tracción incluyen Self-RAG (donde el modelo decide cuándo necesita buscar información adicional) y Corrective RAG (donde el sistema verifica y corrige sus propias respuestas antes de entregarlas).

Estas aproximaciones intentan resolver uno de los problemas persistentes de RAG: que a veces el sistema recupera documentos que no son realmente relevantes, o no recupera nada útil, y el modelo genera una respuesta basándose en información inadecuada.

El enfoque híbrido: lo que realmente funciona

Una lección importante que hemos aprendido es que RAG y fine-tuning no son mutuamente excluyentes. De hecho, la combinación suele dar mejores resultados que cualquiera de los dos por separado.

El patrón que vemos funcionar es: hacer fine-tuning para que el modelo entienda el dominio y el formato de respuesta esperado, y luego usar RAG para inyectar conocimiento actualizado y proporcionar trazabilidad.

Pensemos en un asistente para el sector oleícola (un dominio que conocemos bien). El fine-tuning puede enseñar al modelo la terminología específica (rendimiento graso, campaña oleícola, AOVE), el tono apropiado para el sector, y el formato de respuesta esperado. Luego RAG proporciona acceso a precios actuales, normativa vigente y datos específicos del cliente.

Esta combinación es más compleja de implementar, pero para aplicaciones empresariales serias, suele ser el camino correcto.

Sobre los costes

Es tentador comparar costes de forma simplista, pero la realidad es más compleja.

RAG tiene costes iniciales más bajos. Puedes tener un sistema funcionando relativamente rápido. Los costes recurrentes dependen del volumen de consultas y del proveedor de LLM que uses.

Fine-tuning requiere más inversión inicial: preparar el dataset (que es más trabajo del que parece), entrenar el modelo, evaluar, iterar. Y rara vez aciertas a la primera. Deberías presupuestar múltiples rondas de entrenamiento.

Pero hay un coste que muchas veces se olvida: el coste de oportunidad. Si eliges mal y tienes que cambiar de enfoque a mitad de proyecto, el impacto en tiempo y dinero puede ser significativo.

El mercado de LLMs está en flux constante. Los precios varían enormemente: desde 0.40 dólares por millón de tokens de input en algunos modelos hasta 15 dólares en otros. Los modelos open source como Llama o Mistral pueden reducir costes drásticamente si tienes la capacidad técnica para hostearlos, pero eso implica otros costes (infraestructura, mantenimiento, expertise).

Errores que hemos visto (y cometido)

Después de varios proyectos, hay patrones de error que reconocemos.

Con RAG, el error más común es no prestar suficiente atención a cómo se segmentan los documentos (chunking). Fragmentos demasiado pequeños pierden contexto. Fragmentos demasiado grandes introducen ruido. La estrategia de chunking óptima depende del tipo de documento, y a menudo requiere experimentación.

También hemos visto sistemas donde el retrieval devuelve documentos irrelevantes, pero nadie ha implementado un umbral de similitud mínimo. El modelo usa esa información inadecuada y genera respuestas incorrectas con mucha confianza.

Con fine-tuning, el error más común es subestimar la importancia de la calidad del dataset. Como dice el dicho: garbage in, garbage out. 200 ejemplos excelentes superan a 2000 ejemplos mediocres.

Otro error frecuente es no evaluar regresiones. El fine-tuning puede mejorar el rendimiento en tu tarea específica pero empeorar capacidades generales del modelo. Hay que medir ambas cosas.

Una reflexión sobre el estado actual

Algo que nos ha llamado la atención siguiendo la evolución del campo es que, aunque siguen publicándose papers sobre RAG constantemente, los avances significativos se han ralentizado en 2025. Mucha de la atención se ha desplazado hacia sistemas agénticos.

No creemos que RAG vaya a desaparecer. Al contrario, está madurando y volviéndose “infraestructura” en el mejor sentido. Pero sí creemos que la forma de implementarlo está cambiando, hacia sistemas más sofisticados que combinan múltiples técnicas.

Para quien esté empezando, nuestra recomendación sería: empieza con RAG básico, pero diseña tu arquitectura pensando en que probablemente evolucione hacia algo más complejo. No te cases con una implementación específica.

Y ten en cuenta que el campo se mueve rápido. Lo que hoy es estado del arte puede quedar obsoleto en meses. La flexibilidad para adaptarse es tan importante como la elección técnica inicial.

¿Estás evaluando cómo incorporar LLMs a tu organización? En AIXA AI trabajamos con estas tecnologías y nos gusta compartir lo que aprendemos. Escríbenos si quieres discutir tu caso específico.

Artículos Relacionados

Continúa explorando más contenido sobre Tecnología

Medio Millón de Kilómetros Cuadrados Monitorizados Desde el Espacio

La historia de cómo construimos un sistema para procesar datos satelitales de 28 regiones olivareras mediterráneas. Los desafíos técnicos, las decisiones arquitecturales críticas y lo que aprendimos procesando millones de píxeles de olivos.

Cómo Estamos Construyendo Olearia Intelligence: Lecciones del Camino

Reflexiones sobre el desarrollo de un producto de datos complejo. Los errores que cometimos, las decisiones que acertamos y lo que estamos aprendiendo en el proceso.

Tu Móvil Ya Es Más Inteligente Que el Superordenador de 2020 (Y Eso Es Solo El Principio)

Los NPUs en smartphones alcanzan hasta 47 TOPS y ejecutan modelos que hace apenas tres años requerían datacenters completos. Análisis de la revolución Edge AI que está transformando cómo interactuamos con la inteligencia artificial en 2025.

¿Te ha gustado este artículo?

Recibe más contenido como este directamente en tu correo. Guías prácticas y las últimas innovaciones en IA empresarial.

Sin spam

Datos protegidos